di Nicola Parodi e Paolo Repetto, 17 ottobre 2024

Ci siamo imbattuti ultimamente in una serie di articoli nei quali si ventila che i maggiori siti di Intelligenza Artificiale (AI) stiano accordandosi per assoggettare a pagamento tutti i servizi che erogheranno. La cosa non ci ha indignati, ma ci ha stupiti. Non ci ha indignati perché non avevamo mai avuto il minimo dubbio che sarebbe finita così, e ci ha invece stupiti perché questi articoli trattavano la cosa come un’allarmante “eventualità”.

Ma quale eventualità! Ci sembra tutto così chiaro. Nessuno investe milioni o miliardi di dollari, di euro o di yen che si voglia per offrire un servizio a tutta la comunità umana. Al più potranno essere distribuite gratuitamente un po’ di briciole, quel che rimane sul tavolo dopo essersi spartiti le fette. E neppure le briciole saranno del tutto gratis, perché serviranno soprattutto a farci prendere gusto a quel pane, a rendercelo indispensabile e a indurci a farne un elemento essenziale della nostra dieta. A pagamento, naturalmente.

Per questo riteniamo che tutto il fiorire ultimo di G7 e di convegni e di predicozzi papali sul futuro dell’AI e sulla sua regolamentazione sia solo un teatrino più o meno consapevole di essere tale. Pensiamo che in effetti strumenti di difesa efficaci contro l’abuso e la strumentalizzazione non ce ne siano, e che al più possa essere opposta una consapevolezza, che non può essere che individuale, di come funziona tutta la faccenda. O meglio ancora: di come ha sempre funzionato.

Proviamo a riassumere, senza naturalmente la pretesa di riscrivere la storia dell’uso degli strumenti “intelligenti”, ma solo per buttare lì qualche spunto di riflessione non supinamente ortodosso e non aprioristicamente eterodosso.

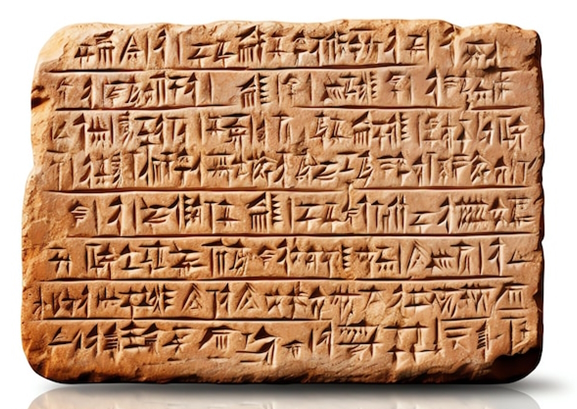

Dunque. Con l’invenzione di “segni impressi manualmente su un substrato” gli umani sono stati svincolati dalla necessità di archiviare nella memoria parole, cose e fatti. Volendo possono essere considerate come substrato originario anche le pareti delle caverne, ma convenzionalmente l’origine della scrittura vera e propria è fissata all’uso di tavolette di argilla, sostituite poi attraverso innovazioni successive da papiri, pergamene o carta. E già lì il problema si poneva, come dimostra l’avversione, o quantomeno la diffidenza, di Platone per la parola scritta. Le ragioni addotte da Platone riguardavano l’appiattimento del discorso che la scrittura automaticamente produce, la sua neutralizzazione, in quanto si azzerano tutte le sfumature che il tono di voce o le espressioni facciali o la postura fisica consentono più o meno volutamente a chi parla di introdurvi, e a chi ascolta di coglierle, ma soprattutto la sostanziale passività che è indotta in chi ne fruisce.

C’era però anche un altro problema, ma questo Platone non se lo poneva, stante la sua concezione di un sapere “elitario”. Le innovazioni tecnologiche hanno permesso di “imprimere i segni” in maniera via via più veloce e meno costosa, e da ultimo anche automatizzata, con la conseguente moltiplicazione dei libri o di altri strumenti di trasmissione del sapere o quantomeno dell’informazione, e quindi hanno aperto l’accesso a quest’ultima ad una platea sempre più vasta. Ma sia per quanto ha riguardato per quattro o cinque millenni la trasmissione scritta che per quanto concerne oggi quella audio-visiva, la platea ha continuato ad essere sostanzialmente passiva (e più che mai lo è diventata di fronte ai media introdotti negli ultimi due secoli): si è nutrita quindi di saperi e di informazioni gestiti e selezionati e distribuiti di volta in volta dai diversi poteri (politici, religiosi, economici, ecc.). Per questo diciamo che la non solo possibile ma più che probabile monopolizzazione dell’AI, e non solo a fini economici ma anche di condizionamento sociale, non rappresenta affatto una novità. È sempre andata così. Con buona pace anche di noi sostenitori della intrinseca positività dell’innovazione tecnologica, dobbiamo ammettere che l’accesso ad un uso “attivo” delle tecnologie che supportano l’informazione e la trasmissione del sapere è consentito ai “non addetti ai lavori” solo quando queste ultime diventano obsolete. Oggi chiunque è in grado di prodursi a costi bassissimi un libro, o di girare un film o di aprirsi uno spazio in rete, ma questo libro o questo film o questo spazio, se non sono inseriti in un meccanismo di mercato che ne condiziona già in partenza la libertà espressiva, finiscono in un mare magnum nel quale non hanno la minima visibilità o rilevanza.

Vediamo comunque cosa ci aspetta. I “segni” cui ci si affiderà per il futuro, pur avendo ancora una loro effimera fisicità, sono “impressi” su un substrato e con tecniche tali per cui possono essere “visti e letti”, ma non lasciano una traccia “fisica” concreta. Vale a dire: questa roba c’è, può essere vista e letta, è rintracciabile velocemente e con facilità, ma in realtà non sappiamo affatto dov’è, con che criteri viene archiviata, e da chi, e a quale scopo. Si, certo, sappiamo che questo lavoro lo fanno i grandi gestori dei big data, ma abbiamo la minima idea di chi ci sia davvero dietro, dei traffici, delle guerre commerciali, degli accordi e degli scambi che si operano ben al di sopra delle nostre teste?

Ma non basta. Un’altra preoccupazione immediata riguarda la resistenza del supporto della fisicità dei dati. Con la progressiva sparizione degli archivi delle burocrazie reali, dei templi e delle biblioteche nei quali i dati erano conservati su supporti fisici, stiamo affidandoci sempre più alla “nuvola”. Con quali garanzie? Un’eruzione solare o una tempesta magnetica particolarmente forte o, senza scomodare la natura, una guerra dissennata combattuta nell’etere, potrebbero riportarci all’età della pietra? Il problema è reale, è già ampiamente discusso, ma noi tendiamo ad autoconvincerci che la tecnologia sarà comunque in grado di rimediare a questi rischi. In fondo, ci diciamo, i supporti vecchio stile hanno permesso una conservazione dei dati aldilà di quanto potevano immaginare i nostri avi: al giorno d’oggi tecnologie d’avanguardia consentono di leggere cosa c’era scritto sulle pergamene prima che venissero raschiate per essere riutilizzate, o addirittura di leggere i papiri ritrovati ad Ercolano. Ma parliamo pur sempre di supporti concreti sui quali lavorare: l’etere è un’altra cosa, e ci si chiede come sarebbe possibile rintracciarvi dati eventualmente dispersi.

Perché ci sono poi anche altri rischi: l’accensione della carta richiede una temperatura tra i 200 gradi e i 350 circa, a seconda dello spessore, e solo un malaugurato incidente o una “milizia del fuoco” come quella di Fahrenheit 451 possono provocarla, mentre il funzionamento dei megaserver nei quali stipiamo oggi le conoscenze necessita di temperature costanti tra i 30 e i 40 gradi. Con i mutamenti climatici in corso sarà sempre più difficile garantirle. Può sembrare una forzatura, ma in realtà abbiamo già modo di constatare quotidianamente come i più sofisticati sistemi di previsione, di prevenzione e di protezione vadano in tilt ad ogni stormir di foglia o ad ogni attacco degli hackers. È vero, anche la biblioteca di Alessandria, così come molte altre, è andata a fuoco, e una infinità di opere del passato è andata perduta: ma lo sappiamo perché di queste opere è rimasta comunque memoria, qualcuno ce ne ha comunque parlato, mentre ciò che finisce nella nuvola difficilmente ridiscenderà sulla terra come pioggia a fecondare i cervelli: è più probabile che si vaporizzi nel nulla. Rimane allora il dubbio che possano un giorno tornare utili i cinquanta e passa tomi della vecchia Treccani che Paolo ha messo al sicuro nel Capanno.

La preoccupazione maggiore e più attuale concerne però, come si diceva sopra, il rischio dell’appropriazione indebita del sapere da parte di società private fornitrici di servizi di AI. La cultura attuale è un frutto collettivo, prodotto dall’umanità durante tutta la sua storia, anche se con una accelerazione esponenziale negli ultimi millenni. Le varie società private utilizzeranno questo patrimonio dell’umanità per fare profitti, e potranno decidere quale conoscenza può essere fatta circolare o quale è meglio tenere riservata per i loro fini, politici o economici che siano. Un po’ come accadeva nella biblioteca dell’abbazia ne Il nome della rosa. Permettendoci di interrogare i loro sistemi ci daranno poi un’illusoria ed effimera sensazione di essere colti, mentre in realtà saremo solo consumatori di un prodotto culturale pre-confezionato e incartato, di uno spettacolo cui assistere passivamente.

Ripetiamo: è sempre stato così, il sapere e l’informazione trasmessi sono sempre stati trattati e normalizzati in funzione di chi ne deteneva il possesso (si pensi solo al lavoro di “ripulitura” dei testi sacri operato dalle varie chiese – per non parlare di quello della loro “creazione”), e da sempre ci sono individui o gruppi (medici, ingegneri, insegnanti ecc.) che usano le conoscenze prodotte dall’umanità per ricavarne un reddito. Quelle conoscenze sono però frutto di impegno e fatiche personali che hanno portato all’acquisizione di competenze necessarie alla società, che vanno riconosciute e remunerate al pari di quelle di qualunque altro lavoratore, e sono comunque a disposizione di tutti e non riservate ai membri di qualche setta (o azienda). Le modalità stesse della loro detenzione, poi, della conservazione e della circolazione, le hanno rese passibili (almeno negli ultimi secoli, ma in fondo da sempre) di essere confrontate, riviste, confutate: oseremmo dire che ogni innovazione tecnologica da un lato ha ampliato la cerchia degli utenti sui quali la cultura “addomesticata” poteva esercitare influenza, ma dall’altro ha progressivamente eroso a chi la deteneva ampi margini di controllo.

Le nuove tecnologie fanno intuire invece un controllo molto più soft e molto più subdolo: non ci sarà bisogno di alcuna censura, di alcuna proibizione conclamata: provvederà il sistema stesso, offrendo in apparenza possibilità illimitate, ma pilotando sapientemente all’interno del bailamme le nostre aspettative, a liquidare o a banalizzare sul nascere ogni tentazione di eresia o di autonomia di pensiero.

L’idea poi che le leggi, le regole sulle quali si basa la nostra convivenza, possano essere affidate ad un cloud ci inquieta: ricorda un po’ troppo epoche nelle quali le leggi erano garantite dagli Dei, e interpreti della volontà degli Dei erano i sacerdoti, almeno fino a quando non cominciarono ad essere scolpite sulla pietra, da Hammurabi a Mosè alle dodici tavole. La cultura del diritto, della quale tanto si parla, soprattutto a sproposito, nasce proprio da lì, da quelle pietre. Altro che nuvole.

Non vorremmo essere fraintesi. Non stiamo invocando un ritorno all’età della pietra: semmai proprio il contrario. Stiamo dicendo che il modello produttivo, e di conseguenza quello sociale, che abbiamo adottato suppone forme di organizzazione sempre più complesse, che a loro volta richiedono quantità di competenze impossibili da padroneggiare da un singolo. E che laddove la programmazione non possa essere eseguita e gestita dallo stato, cosa che oggi sta accadendo quasi ovunque perché le potenze che guidano il gioco sono ormai transnazionali, subentrano società private che possono investire enormi capitali: e che questi capitali, proprio perché enormi, si sottraggono al controllo di quei cittadini che attraverso lo stato dovrebbero esercitarlo. Alla faccia della democrazia, della libertà e dell’uguaglianza.

Anche questo in qualche modo è già accaduto, sin dalla notte dei tempi storici: la nascita delle città, ad esempio, ha certo liquidato le libertà di cui godevano i cacciatori-raccoglitori del paleoliotico: ma ha anche prodotto degli anticorpi, dapprima marginali, poi sempre più robusti, che hanno conferito alla libertà e alla dignità individuale altri significati (e se siamo qui oggi a parlarne e a porci il problema lo dobbiamo a questa evoluzione culturale). La domanda è se questi anticorpi, davanti alla pervasività che si prospetta totalizzante dell’intelligenza artificiale e al monopolio culturale che questa ambisce ad esercitare, sapranno ancora reagire, escogitare strategie di difesa. Anche in questa direzione i dubbi sono più che giustificati.

Insomma. Se agiranno in regime di “proprietà privata”, le aziende che fanno ricerca nel settore dell’AI, che già si guardano bene dal divulgare i risultati di queste ricerche ma si affrettano piuttosto a tradurli in utili, a trasformarli in un “prodotto” (che come tale ha come destinazione naturale un mercato e come scopo un profitto), metteranno in vendita qualcosa che non appartiene loro, che è un capitale comune maturato dall’umanità. Non solo: lo faranno esercitando una discrezionalità totale, promuovendo o oscurando i dati in loro esclusivo possesso a seconda degli interessi in gioco. E infine, comunque la si metta, anziché agevolare il recupero o il potenziamento di quella intelligenza naturale che tanto sembra oggi difettare, c’è il rischio concreto che ne sanciscano la definitiva atrofizzazione.

A conti fatti, non sembriamo messi troppo bene.

Postilla. L’Enciclopedia Treccani di cui sopra mi è stata regalata da una conoscente una decina d’anni orsono, forse proprio per fare posto al digitale. Consta dei trentasei volumi dell’edizione originaria, pubblicati tra il 1929 e il 1937, più altri quattordici di Appendici aggiornate sino al 1992 e uno di apertura sul nuovo millennio. È insomma come quelle che di recente, a partire dall’era Covid, avete visto alle spalle di molti dei partecipanti da remoto ai talk televisivi. La mia è ospitata nel Capanno dei Viandanti (che peraltro non ne fanno granché uso), perché in casa occuperebbe almeno la metà di una parete, mentre già attualmente non rimane spazio nemmeno per una rivista. Non apparirà mai in tivù non perché è esiliata al Capanno, ma perché io non frequento i talk.

Ci torno su invece perché offre a mio giudizio un esempio particolarmente ambiguo di trasmissione di “cultura” intesa come “prodotto finito”, summa dei dati e dei saperi. Questo “prodotto culturale” viene infatti riproposto in tempi diversi nella stessa confezione, anche se gli ingredienti e le ricette sono spesso completamente differenti. Non è questa la sede, ma sarebbe interessante analizzare le correzioni, le variazioni o le cancellazioni conosciute nell’arco di mezzo secolo da alcune “voci” particolarmente significative (ad esempio, dalla voce: razza).

Ora, certamente la cultura è un continuo processo conoscitivo, ed è quindi normale che i dati si aggiornino e i punti di vista mutino: ma è inquietante constatare come l’involucro abbia conservato, e trasmesso al contenuto, sempre la stessa autorevolezza (e sua la presenza come convitato di carta nei salotti televisivi mira proprio a questo). È inquietante perché di un’identica proprietà sembra godere oggi ogni confezione digitale, e senza nemmeno che vengano a incrinarla gli Aggiornamenti.

Per il momento mi limito a sottolineare come sulla Treccani queste voci fossero comunque affidate a specialisti, che si presumeva avessero una preparazione specifica, e che firmavano i lemmi (per cui era possibile con poco sforzo determinare le loro coordinate), mentre le odierne enciclopedie digitali, prima tra tutte Wikipedia (della quale peraltro mi avvalgo), hanno alle spalle collaborazioni volontarie e anonime: ciò significa che quando va bene queste collaborazioni soffrono di dilettantismo, di scarsa accuratezza nella verifica delle fonti, di datazioni o attribuzioni errate, ecc… mentre quando va male nascono da un preciso intento di interpretazione e strumentalizzazione ideologica (intere aree storiografiche, ad esempio quella relativa al fascismo, sono state prontamente colonizzate da una storiografia di destra decisamente d’accatto: ma questo vale anche purtroppo per la sinistra). Ebbene, sul web tutte queste voci hanno pari dignità, e stanti i criteri quantitativi coi quali l’algoritmo ne decreta la rilevanza (in sostanza, il numero di accessi), e quindi l’ordine di comparsa sullo schermo, è evidente che tale “rilevanza” non potrà che crescere nel tempo.

Questo ci riporta direttamente all’intelligenza artificiale e alle prospettive che apre. L’interrogativo che ricorre con maggiore frequenza nelle discussioni sull’argomento riguarda la possibilità o meno dell’AI di riprodurre esattamente, e di potenziare, tutti i meccanismi e le funzioni intellettive del cervello umano: quindi non solo di eguagliare, ma di superare le capacità della nostra mente. La risposta che io mi davo sino a ieri era che esiste anche una intelligenza del corpo, che passa per i nostri sensi prima ancora che per la mente, e che non può essere clonata da una macchina. Oggi non ne sono più tanto sicuro, e comunque non importa, perché credo invece che sia malposta la domanda. Penso infatti che quello in corso non sia un processo di adeguamento dell’intelligenza artificiale a quella umana ma, al contrario, di adeguamento dell’intelligenza umana a quella artificiale. Tutti i nostri comportamenti, in effetti, e non solo quelli mentali ma anche quelli fisici, sono già sin da ora, quando di AI si parla ancora come di un progetto allo stato nascente, fortemente condizionati da protesi, da strumentazioni, da modalità di comunicazione e di spostamento che riconfigurano lo spazio e il tempo, dilatano e sterilizzano i rapporti, dettano le priorità, rimodellano le aspettative. Io stesso, che siedo in questo momento davanti a un computer, sto scrivendo in una modalità che da un lato sembra offrirmi possibilità infinite di ripensamento, di correzione, di controllo lessicale, di approfondimento, di verifiche e di ricerche in tempo reale, senza alzarmi dalla sedia, ma dall’altro mi induce una pigra dipendenza, mi asseconda se mi conformo ai suoi protocolli di scrittura e silenziosamente indirizza e influenza ciò che scrivo.

Insomma, sono io ad abituarmi a pensare come la macchina, e non viceversa. (P. R.).